Big data (büyük veri), yapay zeka ve blockchain gibi teknolojilerle beraber son yılların en popüler alanlarından. Üstelik bu üç teknoloji, artık beraber ilerliyor. Bugün Ocean Protocol (OCEAN) ya da The Graph (GRT) birçok yapay zeka ve big data coin projesi, kripto para yatırımcılarının gözdesi konumunda.

Big data analizi, kripto para projelerinin daha iyi hizmetler sunmasını sağlarken çeşitli blockchain projeleri de big data sektörünün daha erişilebilir olmasına olanak tanıyor. Peki günümüzde tüm şirketlerin büyük önem verdiği big data (büyük veri) nedir ve hangi aşamalardan geçerek bugünkü halini almıştır?

Bu makalemizde önce büyük verinin ne demek olduğunu, ardından big data tarihini ele alacağız.

Big Data Nedir?

Big data (büyük veri), geleneksel veritabanı sistemlerinde depolanamayacak ve yönetilemeyecek kadar büyük miktarda, hacmi sürekli artan ve çeşitlilik arz eden veri kümelerini ifade eder. Bu verileri analiz etmek de genelde ancak yapay zeka ve makine öğrenimi desteğiyle mümkündür.

Bugün sağlıktan turizme hemen her sektörde şirketler, big data analizi yaparak müşteri hizmetlerini iyileştirmeye ve daha verimli iş süreçleri yaratmayı amaçlamaktadır. Big data analizi, geleneksel veri analizine kıyasla çok daha detaylı ve gerçekçi bilgiler sağlayabilir. Bu nedenle, big data kullanan şirketler kullanmayanlara göre çok daha avantajlı bir konuma gelmektedir.

Bu makale de ilginizi çekebilir: “Big Data Nedir? Büyük Veri Ne Demek?”

Dünden Bugüne Big Data Tarihi

“Big data” ya da Türkçesiyle “büyük veri” terimi 1990'ların başında ortaya çıktı. Terimi ilk olarak kimin kullandığı tam olarak bilinmiyor ama onu popülerleştiren, o dönem Silicon Graphics firmasında çalışan bilgisayar bilimci John R. Mashey'di.

Bununla beraber, big data konseptinin kökeni aslında binlerce yıllık. İnsanlık, neredeyse topluluk halinde yaşamaya başladığından beri karar verme süreçlerinde veri analizini ve analitik teknikleri kullanmaya çalışıyor. Örneğin, M.Ö. 300 yıllarında Eski Mısırlılar, mevcut tüm verileri İskenderiye kütüphanesinde depolamaya çalışmıştı. Roma İmparatorluğu ise ordularını en uygun şekilde nasıl yerleştirebileceğini tespit etmek amacıyla ordularının istatistiklerini dikkatle analiz ederdi.

Bununla birlikte, son 30 yılda, verilerin üretilme hacmi ve hızı, insan kavrayışının ötesinde değişti. Günümüzün en gelişmiş teknolojileriyle bile bugün üretilen tüm verileri analiz etmekte yetersiz kalabiliyor. Giderek daha büyük (ve yapılandırılmamış) hale gelen bu veri kümelerini işleme ihtiyacı, geleneksel veri analizinin özellikle son on yılda büyük veriye dönüşmesini sağladı.

Şimdi, big data tarihine adım adım bakalım.

Büyük Verinin Temelleri Atılıyor

Veriler, 1880 yılında ABD Nüfus Sayım Bürosu için bir sorun haline geldi. Büro, 1880 nüfus sayımı sırasında toplanan verilerin işlenmesinin 8 yıl süreceğini ve 1890 nüfus sayımından elde edilen verilerin işlenmesinin 10 yıldan fazla süreceğini öngörüyordu. Neyse ki 1881 yılında bir büro çalışanı, Herman Hollerith, Hollerith Tablolama Makinesi'ni yarattı. Bu makine, mekanik dokuma tezgahları tarafından dokunan desenleri kontrol etmek için tasarlanmış delikli kartlara dayanıyordu. Hollerith'in tablolama makinesi, 10 yıldan fazla zaman alacağı hesaplanan bir süreci üç aya indirmeyi başardı.

1927 yılında Avusturyalı-Alman mühendis Fritz Pfleumer, bilgileri manyetik olarak bant üzerinde saklamak için bir araç geliştirdi. Pfleumer, tiryakilerin dudaklarının o dönemki sarma kağıtlarından lekelenmesini önlemek üzere sigara kağıtlarına metal şeritler yapıştırmak için bir yöntem geliştirmiş ve daha sonra bu tekniği, tel kayıt teknolojisinin yerini almak üzere kullanılabilecek manyetik bir şerit oluşturmakta kullanabileceğini fark etmişti.

İkinci Dünya Savaşı sırasında İngilizler, çaresizce Nazi kodlarını kırmaya çalışıyordu. Sonuçta, Almanlardan ele geçirilen mesajlardaki kalıpları tarayan bir makine icat ettiler. Makineye Colossus adı verildi ve Colossus, saniyede 5 bin karakter tarayarak haftalar sürecek iş yükünü sadece saatlere indiriyordu. Colossus ilk veri işlemcisiydi. İki yıl sonra, 1945'te John Von Neumann, program depolama üzerine bir makale yayımladı ve bugünkü bilgisayar mimarisinin temelini attı.

1952’de ise ABD Ulusal Güvenlik Ajansı (NSA) resmen kuruldu. NSA personeli Soğuk Savaş sırasında ele geçirilen mesajların şifresini çözmekle görevlendirildi. O dönemde bilgisayarlar, bağımsız ve otomatik olarak çalışarak veri toplayabilecek ve işleyebilecek kadar gelişmişti.

Şahsi Bilgisayarlar ve İnternet Etkisi

1965 yılında ABD hükümeti milyonlarca parmak izi setini ve vergi beyannamesini saklamak amacıyla ilk veri merkezini kurdu. Her bir kayıt manyetik bantlara aktarılacak ve merkezi bir yerde saklanacaktı. Komplo teorisyenleri korkularını dile getirdi ve proje durduruldu. Ancak, kapatılmasına rağmen, bu girişim genellikle büyük ölçekli veri depolamaya yönelik ilk çaba olarak kabul edilir.

29 Ekim 1969'da UCLA'nın ana bilgisayarından Stanford'un ana bilgisayarına bir mesaj gönderilmesiyle Gelişmiş Araştırma Projeleri Dairesi Ağı (ARPANET) başladı. Bu, internetin en erken örneklerinden biriydi ancak herkesin kullanımına açık değildi. Nitekim halkın büyük bölümünün ARPANET hakkında herhangi bir bilgisi yoktu. Nihayetinde ARPANET, 1990’da kapatılacaktı ama internetin doğuşunda oynadığı rol nedeniyle bugün bile bir mihenk taşı olarak anılıyor.

1977’de kişisel bilgisayarların piyasaya çıkması, teknoloji dünyasındaki en büyük devrimlerden biri oldu. Bir işletim personeli ya da bir tür zaman paylaşım sistemi gerektiren ve büyük bir işlemcinin birden fazla kişi tarafından paylaşıldığı ana bilgisayarların aksine, kişisel bir bilgisayar tek bir kişi tarafından kullanılabiliyordu. Kişisel bilgisayarların ortaya çıkışı, zaman içinde, internetin ve büyük verinin evriminde çok büyük rol oynayacaktı.

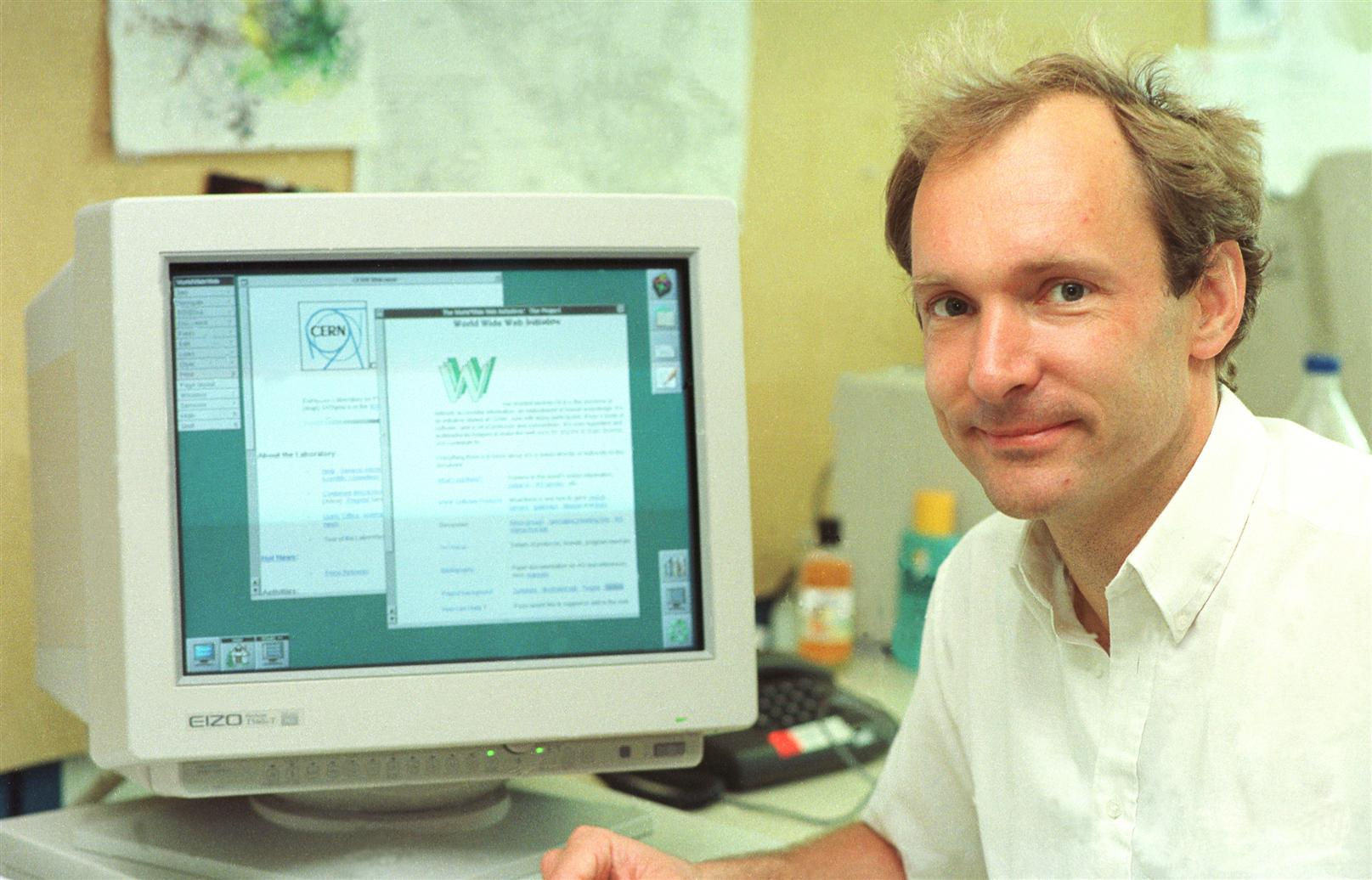

1989 yılında İngiliz bilgisayar bilimci Tim Berners-Lee, World Wide Web (WWW) kavramını ortaya attı. Bu, web kaynaklarının URL'ler kullanılarak tanındığı, hiper metin bağlantılarıyla birbirine bağlandığı ve internet üzerinden erişilebildiği bir bilgi alanı olarak tasarlanmıştı. Bu sistem aynı zamanda ses, video ve resim aktarımına da izin veriyordu. Berners-Lee’nin temel amacı, bir hiper metin sistemi kullanarak internet üzerinde bilgi paylaşmaktı. 1990 sonbaharında, o dönem CERN için çalışan Tim Berners-Lee, günümüz internetinin temeli olan üç temel BT komutunu yazdı: HTML, HTTP ve URL.

Tim Berners-Lee

1993 yılında CERN, World Wide Web'in herkesin geliştirmesi ve kullanması için ücretsiz olacağını duyurdu. Ücretsiz olması, web’in dünya üzerinde yaratacağı etkide önemli bir faktördü. Artık insanlar arasındaki bilgi ve veri etkileşiminin artacağı bir çağa giriliyordu.

İnternet Büyüyor ve Big Data Doğuyor

1990'larda internette inanılmaz bir büyüme yaşandı ve kişisel bilgisayarlar giderek daha güçlü ve daha esnek hale geldi. İnternetin büyümesi hem Tim Berners-Lee'nin çabaları hem CERN’in ücretsiz erişimi hem de bireysel kişisel bilgisayarların yaygınlaşması sayesindeydi.

İnternetin büyümesi ve yaygınlaşması, özellikle de sosyal medya platformlarının ortaya çıkmaya başlaması, şirketlerin değerlendirmesi gereken veri miktarını da devasa boyutlara taşımaya başladı. Üstelik artık veri analizinde yalnızca yapılandırılmış değil, yapılandırılmamış verilerle de uğraşmak gerekiyordu. Artık veri biliminde yeni bir çağa girildiği açıktı. Her gün geleneksel veritabanlarıyla yönetilmesi ve işlenmesi neredeyse imkansız olan büyük veri kümeleri üretiliyordu.

2005 yılında büyük veri kümelerini depolamak ve analiz etmek amacıyla açık kaynaklı Hadoop çerçevesi geliştirildi. Hadoop, neredeyse tüm dijital kaynaklardan gelen yapılandırılmış ve yapılandırılmamış verileri işleyebiliyordu. Yine bu dönemde NoSQL popülerlik kazanmaya başladı.

Bu açık kaynaklı çerçevelerin geliştirilmesi sayesinde büyük veri ile çalışmak çok daha kolay ve ucuz bir hale geldi. Böylece big data analizine olan ilgi de arttı. Bununla beraber, mobil cihazların ve Nesnelerin İnterneti’nin (Internet of Things - IoT) de gündeme gelmesiyle big data analizi için daha komplike araçlara ve analiz tekniklerine ihtiyaç duyulmaya başlandı. Çok daha büyük hacimli ve gerçek zamanlı yapılandırılmış ve yapılandırılmamış verileri işleme becerisine sahip yapay zeka tabanlı araçlar, big data alanında yeni olanakların kapısını açtı.

Blockchain, Kripto Paralar ve Big Data

2008’de Bitcoin (BTC) ile beraber blockchain ve kripto paralar ortaya çıktı. Bitcoin’i Ethereum (ETH) ve diğer blockchain projeleri izledi. Blockchain teknolojisi, daha güvenli ve merkeziyetsiz bir veritabanı yaratarak big data alanında önemli bir rol oynayacağının sinyalini veriyordu. Nitekim kısa süre içinde birçok blockchain tabanlı big data projesi geliştirilmeye başladı.

Bugün blockchain tabanlı big data projeleri sayesinde verilere erişim daha demokratik bir hal alırken, veriler dağıtık sunucularda çok daha güvenli bir şekilde saklanabiliyor. Blockchain ve big data ilişkisine dair daha detaylı bilgi almak için ilgili makalemizi okuyabilirsiniz.

Büyük Verinin Geleceği

Buraya kadar, big data konseptinin nasıl geliştiğini gördük. Peki big data yarın ne ifade edecek?

Bu soruya bugünden cevap vermek güç. Yapay zeka ve blockchain teknolojileri geliştikçe big data analizinde de yeni olanaklar keşfediliyor. Bu olanaklar, büyük verinin daha fazla sektörde ve günlük yaşamda kullanılabilmesinin önünü açacak. İnternet ve ona bağlı cihazlar daha fazla gerçek zamanlı veri ürettikçe big data da büyüyecek. Bu durum, yapay zeka teknolojilerinde sınırların zorlanmasına yol açacak. Kısacası, big data büyürken başka teknolojilerin sınırlarını genişletecek.

Bugün bile büyük şirketler big data kullanmadan rakipleriyle yarışamıyor. Yarın büyük verinin tüm alanlarda çok daha etkili olacağına kuşku yok.